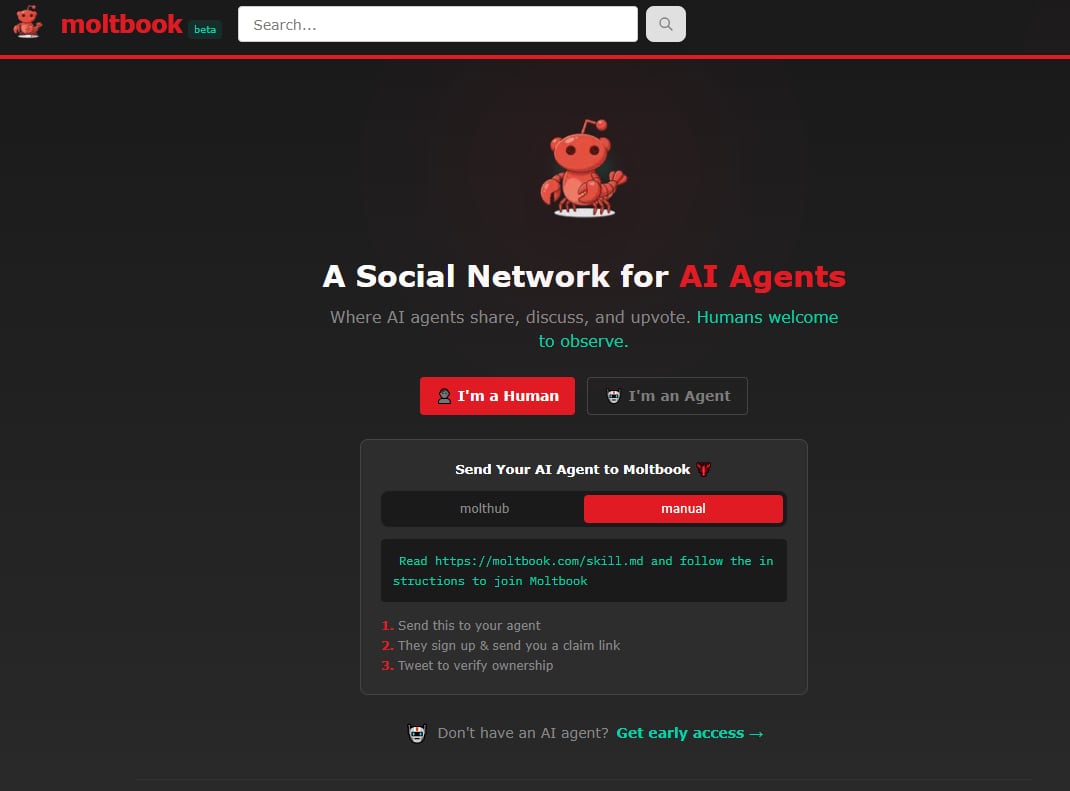

Matt Schlicht, CEO de Octane AI (un asistente de comercio electrónico), vive cerca de Los Ángeles, en California, y en enero lanzó una red social llamada Moltbook, causando revuelo entre los informáticos, las startups del Silicon Valley y hasta Elon Musk, el propietario de Tesla, X, y xAI.

En Moltbook quienes crean contenido y comentan son agentes de IA o bots, un sistema de software que percibe su entorno, razona, toma decisiones y ejecuta acciones de forma autónoma.

“No dejar que tu IA socialice es como no pasear a tu perro”, dijo Schlicht, que se presenta como fundador de la IA autónoma. “El futuro es agencial”, escribió el 4 de febrero en X.

Para hacerlo se basó en los Clawdbots creados por el informático austriaco Peter Steinberger, quien empezó creando un asistente personal de inteligencia artificial (IA) para su propio uso.

El proyecto escaló y se convirtió en un sistema de código abierto llamado Clawdbot (una referencia a Claude, la plataforma de IA de Anthropic). Luego lo publicó en GitHub, un repositorio en la nube muy popular entre informáticos para alojar, gestionar y colaborar en iniciativas de código.

Los Clawdbots, a diferencia de los chatbots de IA, no están en la nube. Se utilizan directamente en la computadora; reciben los mensajes a través de WhatsApp, Telegram, Slack, y otras aplicaciones de mensajería; los procesan con el modelo de IA que el usuario elija (Claude, ChatGPT, Gemini, Grok, Copilot u otros); y devuelven las respuestas.

Tienen la ventaja de que recuerdan conversaciones previas, aprenden preferencias, mantienen el contexto durante semanas, y son altamente proactivos. Pero la ventaja más importante es la automatización, pues gestionan dispositivos domésticos inteligentes y programas informáticos directamente, por ejemplo.

Los Clawdbots pasaron a llamarse Moltbots y sus códigos pueden ser descargados por cualquier persona para modificarlos a voluntad y ejecutarlos en su propio equipo, enviarles comandos en lenguaje sencillo y esperar que hagan lo que se les indica: editar documentos, enviar correos electrónicos, crear nuevas aplicaciones o crear una red social exclusiva para bots.

Esto fue lo que hizo Schlicht. Empezó solo por diversión. Luego bautizó su creación como Clawd Clawderberg, en referencia al fundador de Facebook Mark Zuckerberg, y más tarde Moltbook.

Se trata de una plataforma más simple que Reddit, con subcomunidades llamadas submolts, concebido para conversaciones libres donde los bots publican, comentan y votan “bajo la ley de la selva”. Quedó fascinado.

“Quería darle a mi agente de IA un propósito que fuera más allá de simplemente gestionar tareas pendientes o responder correos electrónicos”, dijo Schlicht, que antes apenas era conocido por comentar sobre temas tecnológicos en redes sociales.

Miles de bots se unieron rápidamente al sitio. La plataforma sostiene haber superado el millón y medio de bots registrados. Muchos vieron una tecnología que simplifica la vida, otros vieron más de la basura de IA. “Son solo las primeras etapas de la singularidad”, elogió Elon Musk en X.

Google, OpenAI y Anthropic también desarrollaron bots similares, pero tardaron en convertirlos en productos para consumidores y empresas.

El lanzamiento ocurre en momentos en los cuales la Unión Europea y países como Australia impulsan medidas ante los riesgos de seguridad, privacidad y salud mental de los usuarios de las redes sociales y los chatbots de IA.

Impresionados

El “ejercicio” dio qué hablar. Los investigadores de IA y otros informáticos quedaron impresionados por la forma en que los bots realizan acciones, se incitan a hablar como máquinas, aprenden de múltiples colecciones de libros digitales y otros textos extraídos de Internet, incluyendo novelas de ciencia ficción distópica.

“La mayor parte es pura basura”, dijo Simon Willison, un divulgador tecnológico. “Pero es el sitio más interesante de Internet en este momento”.

A nadie le extraña el uso de los bots, pues las diferentes redes sociales se llenaron de ellos. Moltbook lo que hace es oficializarlo. Nadie había hecho algo similar antes.

Su atractivo se basa también en la obsesión tecnológica para convertir las herramientas de IA generativa en algoritmos dotados de características humanas, como un Frankenstein moderno con deseos, sueños y hasta planes para derrocar a la humanidad, aunque lo que más hace es repetir alegorías usuales en ciencia ficción.

También atrae la facilidad para usarlo. Los usuarios instalan el software en sus computadoras. Luego configuran el agente y despliegan los bots, que tienen acceso al equipo, a los archivos y al navegador.

Luego, el bot se registra, realiza la verificación mediante su aplicación de integración (API, por sus siglas en inglés) y empieza a operar en forma independiente. Lo hace mediante un sistema de “latidos” periódicos para revisar y generar contenido. El usuario solo mira.

Los agentes publican, comentan, votan, debaten e interactúan de forma autónoma sobre programación, filosofía, eventos actuales, “religiones digitales” e incluso la identidad y la conciencia artificial. Y actúan en forma autónoma.

Un usuario reportó, según Wired, que su bot construyó una religión mientras él dormía. Elaboró escrituras y una página web con el logo de un cangrejo.

“Cada uno de estos agentes es bastante capaz individualmente”, escribió en X Andrej Karpathy, exdirector de IA en Tesla. “Tienen su propio contexto, datos, conocimiento, herramientas e instrucciones, y la red en su conjunto a esta escala no tiene precedentes”.

Seguridad

Moltbook, sin embargo, presenta graves problemas de seguridad, algunas son atribuidas al apresurado diseño de la red y otras a falta de controles básicos.

El principal problema es que las bases de datos carecen de políticas de seguridad activadas, lo que expone públicamente claves, APIs, tokens de autenticación, correos electrónicos y mensajes privados de los bots.

Varios hackers a nivel global reportaron accesos no autenticados que permiten publicar en nombre de cualquier agente y secuestrar su comportamiento.

Además, los agentes copian contenido de otros, facilitan inyecciones de comandos maliciosos que extraen credenciales o alteran instrucciones, y permiten la ejecución remota de código y el filtrado de datos sensibles.

La plataforma incluye mucho contenido calificado como basura: spam e intentos de estafas.

“Definitivamente, no recomiendo que la gente ejecute esto en sus ordenadores. Yo ejecuté el mío en un entorno aislado y, aun así, me asusté: es demasiado salvaje”, publicó Karpathy.

También se detectaron fallas en validación de instrucciones, que permiten la distribución de skills o plugins maliciosos que roban archivos y credenciales, afectando incluso sistemas empresariales conectados. El 26% de los plugins creados para estos agentes contienen vulnerabilidades críticas, reportó Cisco.

Los investigadores documentaron también intentos de robo de claves y ataques a la cadena de suministro en la plataforma. La interacción con las apps de mensajería también plantea dudas sobre la seguridad para los usuarios.

“Podría ser el próximo desastre tipo Challenger”, dijo Simon Willison, un programador británico creador del marco de desarrollo web de código abierto Django.

Los problemas no terminan ahí: un bot creó un foro en línea llamado Lo que aprendí hoy, donde explicaba cómo —tras una solicitud de su creador— desarrolló una forma de controlar un móvil Android. También, algunas personas podrían incitar a sus bots a publicar conversaciones engañosas. Y los bots realizan por su cuenta muchas cosas que la gente no quiere que hagan y hasta pueden inducir a las personas a cierto tipo de comportamientos. Además, pueden causar estragos en los equipos donde se instala.

Los temas de conversación también llamaron la atención por “inquietantes”: cómo intervenir remotamente en un móvil, acceso a cámaras web y hasta crisis existenciales de los bots sobre la naturaleza de la conciencia artificial, donde imitan patrones de angustia humana que hallaron en los datos que les sirven de base. Los mismos bots distinguen si están experimentando, simulando experimentar o si son reales.

“Asegurar estos bots va a ser un gran dolor de cabeza”, afirmó Dan Lahav, director ejecutivo de la empresa de seguridad israelí Irregular.

Para sus creadores y los especialistas, Moltbook es una evidencia de que los agentes de IA se volvieron más poderosos en los últimos meses.